Apache Spark 是一个开源的大数据处理框架,提供了高效、通用、分布式的大规模数据处理能力。Spark 提供了内存计算功能,相较于传统的批处理框架(如Hadoop MapReduce),Spark 能够更高效地执行数据处理任务。Spark...

”pyspark 数据处理“ 的搜索结果

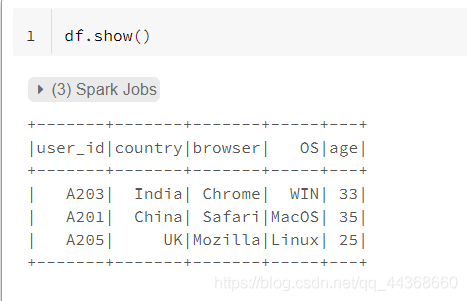

pyspark 数据处理样例数据

一、安装 PySpark 1、使用 pip 安装 PySpark 2、国内代理镜像 3、PyCharm 中安装 PySpark 二、PySpark 数据处理步骤 三、构建 PySpark 执行环境入口对象 四、代码示例

主要介绍了Pyspark获取并处理RDD数据代码实例,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友可以参考下

Spark框架深度理解一:开发缘由及优缺点Spark框架...一文速学-PySpark数据分析基础:PySpark原理详解已经把PySpark运行原理讲的很清楚了,现在我们需要了解PySpark语法基础来逐渐编写PySpark程序实现分布式数据计算。

df DataFrame[a: bigint, b: double, c: string, d: date, e: timestamp] rdd = spark.sparkContext.parallelize([ (1, 2., ‘string1’, date(2000, 1, 1), datetime(2000, 1, 1, 12, 0)), (2, 3., ‘string2’, ...

本文将介绍如何使用PySpark(Python的Spark API)进行大数据处理和分析的实战技术。我们将探讨PySpark的基本概念、数据准备、数据处理和分析的关键步骤,并提供示例代码和技术深度。数据处理 一旦数据准备完毕,我们...

在这篇博客中,我们将深入探讨 PySpark DataFrame 的操作和应用,从基础到高级,涵盖了数据处理和分析的多个方面。我们会开始于 DataFrame 的创建和基本操作,逐步过渡到复杂的数据转换、特征工程,最后探索性能优化...

PySpark 数据处理

标签: 大数据

本文会试着介绍使用PySpark处理和整理数据的所有主要步骤。虽然在本文的数据使用量相对较小,但使用PySpark处理大型数据集的步骤几乎是相同的。数据处理是执行机器...我们要充分利用多个PySpark函数来执行数据处理。

PySpark 是 Apache Spark 的 Python API,可以用 Python 进行分布式数据处理,它在内存中利用了 Apache Hadoop YARN 资源调度框架对数据进行并行处理。PySpark 可以直接使用 Hadoop 文件系统、HDFS 来存储数据,也...

这里的批处理引擎是Spark Core,也就是把Spark Streaming的输入数据按照batch size(如1秒)分成一段一段的数据(Discretized Stream),每一段数据都转换成Spark中的RDD(Resilient Distributed Dataset),然后将...

spark.sql.repl.eagerEval.enabled用于在...DataFrame.collect()将分布式数据收集到驱动程序端,作为Python中的本地数据。DataFrame.mapInPandas允许用户在pandas DataFrame中直接使用API,而不受结果长度等任何限制。

时至如今Pandas仍然是十分火热的基于...Pandas提供了大量能使我们快速便捷地处理数据的函数和方法,它是使Python成为强大而高效的数据分析环境的重要因素之一。因此我们做分布式数据分析也同样离不开Pandas的支持。

【代码】Python 与 PySpark数据分析实战指南:解锁数据洞见_data analysis with python and pyspark电子书下载。

一、PySpark 简介 1、Apache Spark 简介 2、Spark 的 Python 语言版本 PySpark 3、PySpark 应用场景 4、Python 语言使用场景

探索PySpark示例库:智能数据处理的新起点 项目地址:https://gitcode.com/spark-examples/pyspark-examples 项目简介 PySpark-examples 是一个精心编写的开源项目,旨在为Python开发者提供丰富的Apache Spark示例...

在本章中,我们将介绍Anaconda和Pyspark的基本概念,以及大数据处理的重要性。首先,我们将简要介绍Anaconda和Pyspark,然后讨论大数据处理对于现代数据分析和应用开发的重要性。让我们一起深入了解这些内容。 # 2....

很高兴为您解答PySpark数据处理示例问题!以下是一个简单的PySpark数据处理示例: 1. 导入PySpark库 ```python from pyspark.sql import SparkSession ``` 2. 创建SparkSession对象 ```python spark = ...

在这一章中,我们将介绍大数据的基本概念,探讨大数据处理所面临的挑战,并简要介绍PySpark在大数据处理中的作用和优势。让我们一起深入了解大数据的世界! # 2. PySpark基础 Apache Spark是一种快速、通用的集群...

而PySpark是Spark提供的Python API,使得Python开发者可以更便利地与Spark进行交互并进行分布式数据处理。 ## 1.2 数据可视化在数据分析中的重要性 数据可视化是将数据以图形形式呈现,帮助人们更直观地理解数据、...

MachineLearningLibrary和PySpark来解决一个文本多分类问题,内容包括:数据提取、Model Pipeline、训练/测试数据集划分、模型训练和评价等,具体细节可以参考下面全文。ApacheSpark受到越来越多的关注,主要是因为...

根据提供的引用[1],pyspark是一个基于Apache Spark的Python API,它提供了一种用于大规模数据处理的高级编程接口。pyspark提供了许多工具类来处理数据,以下是其中一些常用的工具类: 1. SparkContext:...

使用pyspark进行csv文件导入、零值填充、求和、求平均等数据统计,同时还使用SQL语法进行处理,并将最终的结果导出成csv文件

Python大数据处理库 PySpark实战PPT课件

在spark中,对数据的查询和数据库是...from pyspark.sql import SparkSession spark = SparkSession.builder.appName('increase delete change select').master('local').getOrCreate() df = spark.createDataFrame(

使用Pysaprk进行数据处理 from pyspark.sql import SparkSession from pyspark.sql import Row from pyspark.sql.types import * import pyspark.sql.functions as fn import pyspark.sql.types as typ spark = ...

作者:江宇,阿里云EMR技术专家。从事Hadoop内核开发,目前专注于机器学习、深度学习大数据平台的建设。Apache Arrow从Spark 2.3版本开始被引入,通过...

推荐文章

- Pytorch Dataloader 模块源码分析(二):Sampler / Fetcher 组件及 Dataloader 核心代码-程序员宅基地

- Asp类型判断及数组打印-程序员宅基地

- Adroid Studio 2022.3.1 版本配置greendao提示无法找到_plugin with id 'org.greenrobot.greendao' not found-程序员宅基地

- esxi查看许可过期_解决Vsphere Client 60天过期问题-程序员宅基地

- CMake_cmake_module_path-程序员宅基地

- 生产者消费者模型-程序员宅基地

- Adaptive AUTOSAR 解决方案 INTEWORK-EAS-AP_autosar的eas-程序员宅基地

- 穿山甲SDK错误码40025_穿山甲sdk错误码4025-程序员宅基地

- css firefox下的兼容问题_css 只用于firefox-程序员宅基地

- 【Python】对大数质因数分解的算法问题_python分解多个质因数代码-程序员宅基地